,由于担心信息泄露和其他问题,软银、日立等日本公司已开始限制 ChatGPT 等交互式人工智能服务在商业运作中的使用。

软银上月就使用 ChatGPT 和其他商业应用警告员工称:“不要输入公司身份信息或机密数据。”尽管软银已经出台了使用交互式人工智能等云服务的指导方针,但鉴于聊天机器人最近受到的关注越来越多,这些规则依旧被反复强调。软银计划制定规则,规定哪些业务可以使用该技术,哪些应用可以被使用。

今年 3 月 1 日,ChatGPT 开发商 Open AI 发布了一个应用程序接口,允许企业付费将 ChatGPT 集成到他们的服务中。Open AI 表示,从 ChatGPT 中收集的数据不会用于提高性能,但其网站显示,当这项服务被免费使用时,“我们可能会使用您提供的数据来改进我们的模型。在这种情况下,被输入的信息,例如正在开发的产品,可以用来回答其他公司的问题”。

除软银外,日立将考虑制定新的道德规则,以规范交互式人工智能的使用以及数据是否被正确使用。该公司计划完善 2021 年制定的人工智能使用指南。

富士通上月向员工通报了有关 ChatGPT 和其他交互式人工智能服务的法律和道德问题,包括信息保护。该公司已经成立了一个部门来决定人工智能的使用。2022 年 2 月,富士通成立了一个治理办公室,来处理包含人工智能的产品开发和商业使用中的道德问题。该公司将通过这个办公室提醒公众交互式人工智能的风险。

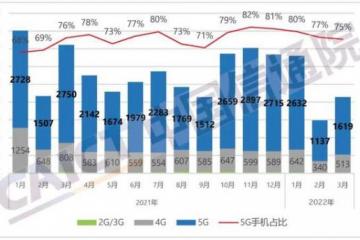

今年 1 月,ChatGPT 在发布仅仅两个月后用户就超过了 1 亿。微软上月在必应搜索中整合 ChatGPT,推动该搜索引擎日用户在一个月后首次突破了 1 亿人。而且,这一技术在企业运作中的应用预计也将显著增加。然而,越来越多的人和企业使用交互式人工智能也令人担忧,因为该技术可能会传播虚假信息,引发数据泄露,导致一些公司禁止使用该技术。

日本瑞穗金融集团、三菱日联金融集团和三井住友银行已禁止在公司运营中使用 ChatGPT 和其他服务。瑞穗的限制措施会阻止员工从工作终端访问该网站,目的是“防止因员工不当使用导致客户和金融交易等重要信息泄露”。IT 公司 NEC 也禁止员工使用 ChatGPT。

日本情报安全大学院大学研究科教授后藤厚宏 表示:“交互式人工智能可以在个人电脑上轻松使用,这让员工变得不那么谨慎,存在机密数据被意外输入并在公司外部使用的风险。这些服务应该由一个专门的内部团队进行测试,以澄清使用规则和可以输入的信息。”

松下控股集团公司 Panasonic Connect 在采取措施防止数据泄露等问题后,开始使用交互式人工智能创建文件。为了降低数据泄露的风险,该公司与软件的联合开发者微软达成了一项协议,不将内容用于人工智能培训等次要目的。同时,员工们也被警告不要输入个人信息。

郑重声明:此文内容为本网站转载企业宣传资讯,目的在于传播更多信息,与本站立场无关。仅供读者参考,并请自行核实相关内容。